特斯拉去年發布的題為「機器自主感知的裝置與方法」的專利,揭露了 FSD 系統的運作方式,並展示如何透過雙網路架構及高度整合的影像處理系統,實現更精確的自動駕駛判斷。專利專家 SETI Park 在社群平台 X 上深入分析了該專利,詳細說明了 FSD 如何透過各項技術模組達到卓越的物體偵測與資料分析效果。

本文主要內容

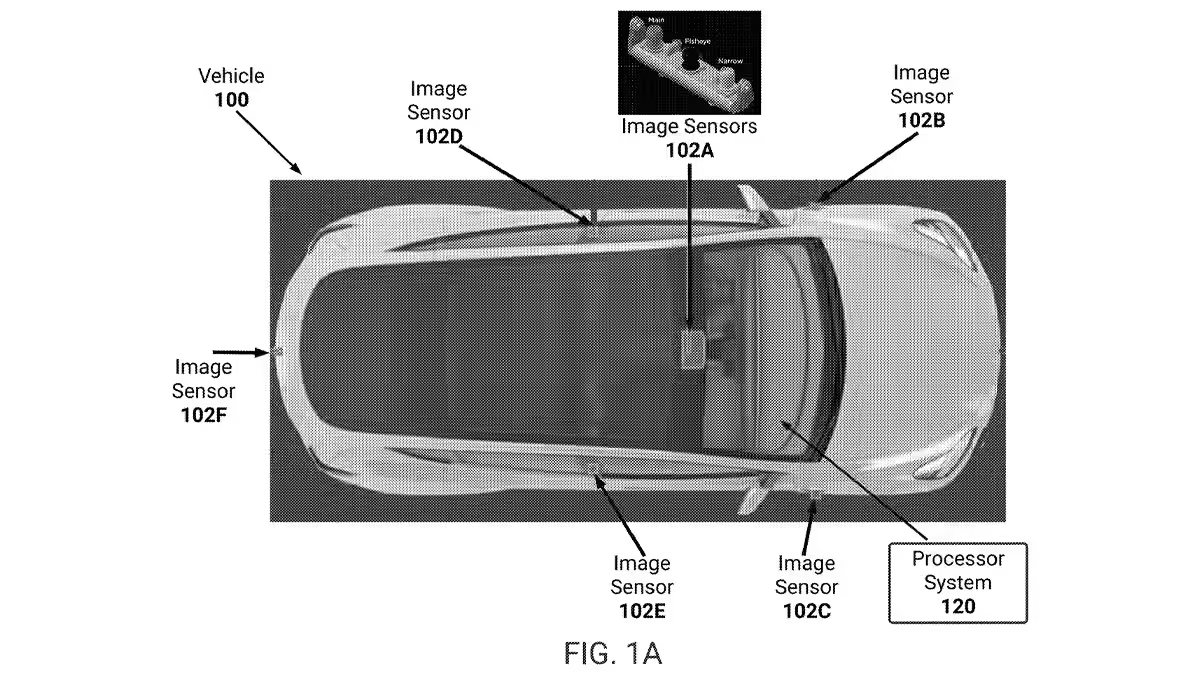

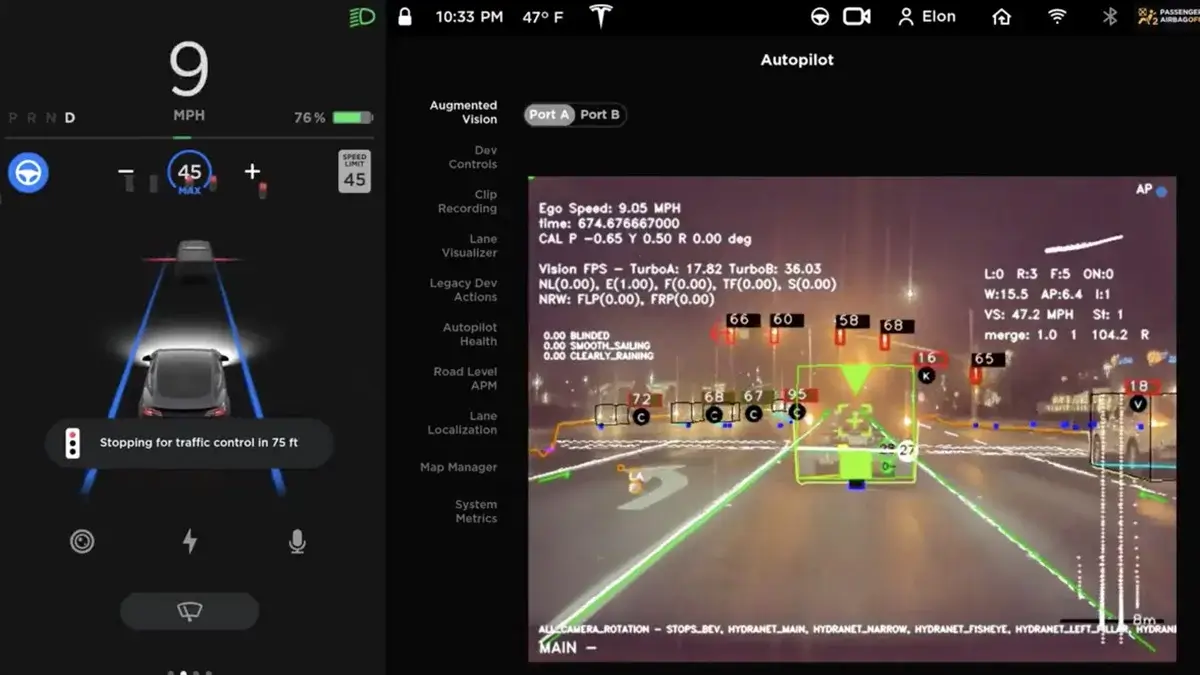

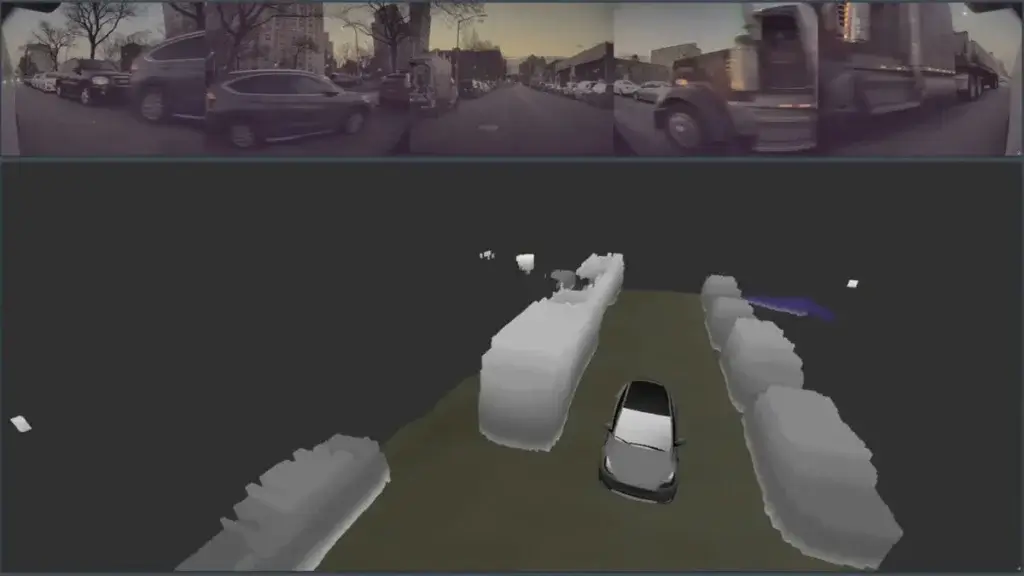

以視覺為基礎的系統:多攝影機環視提升環境理解

這項專利的核心在於特斯拉的「純視覺系統」設計。特斯拉以攝影機取代傳統的雷達與光達,使車輛能夠「看見」並「理解」周圍環境。多個攝影機安裝在車輛四周,其中部分攝影機具有重疊視角,形成 360 度的全景視野,模擬人類環顧四周的方式,但解析度更高、視野更廣,且能同時處理大量資訊。這些攝影機不僅捕捉各個角度的畫面,還能快速適應不同的焦距與透視角度,並整合成連貫的環境圖像。

例如,當行人橫穿馬路時,多攝影機系統能即時捕捉行人的動向,並將資訊傳送至核心系統進行分析。FSD 系統會根據行人的距離、方向與速度即時調整行車策略,例如減速或停車。

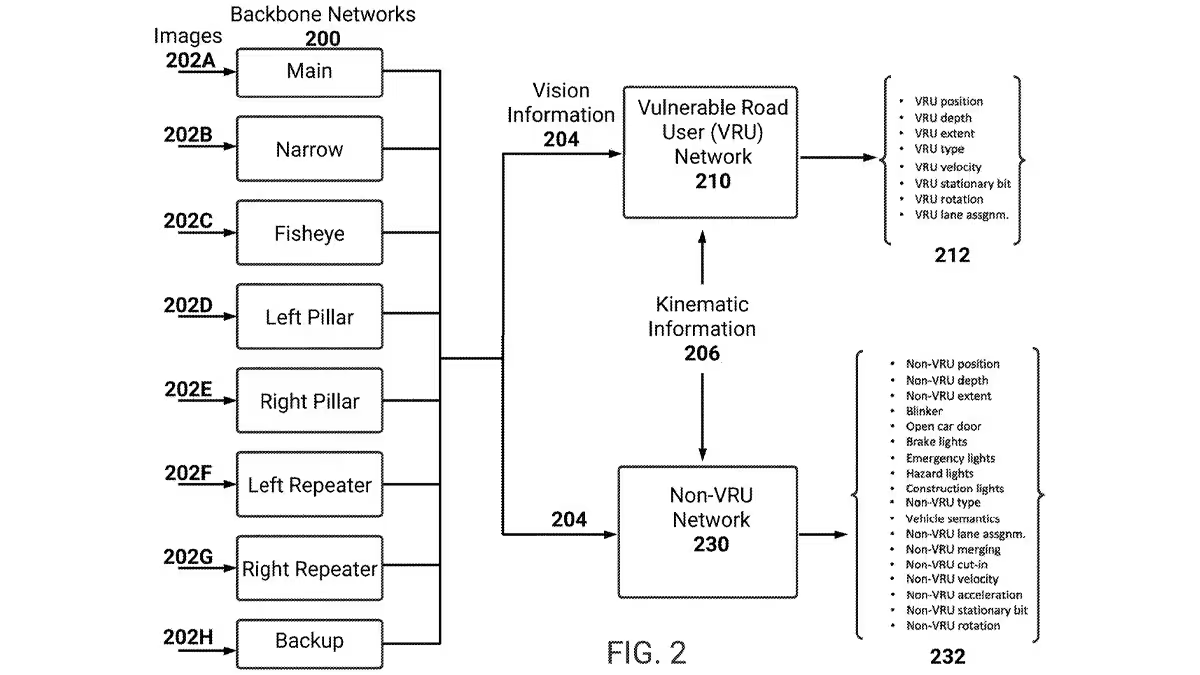

雙網路架構:分流不同類型的道路使用者

FSD 系統採用雙網路架構,分為「易受傷害道路使用者網路」(VRU 網路)和「非 VRU 網路」。VRU 網路專門負責偵測行人、自行車騎士、小動物等相對脆弱的使用者,而非 VRU 網路則處理其他車輛、緊急救援車輛、交通錐和路障等物體。這樣的分支架構允許系統依據物體特性優先分流處理,確保 VRU 優先受到保護。

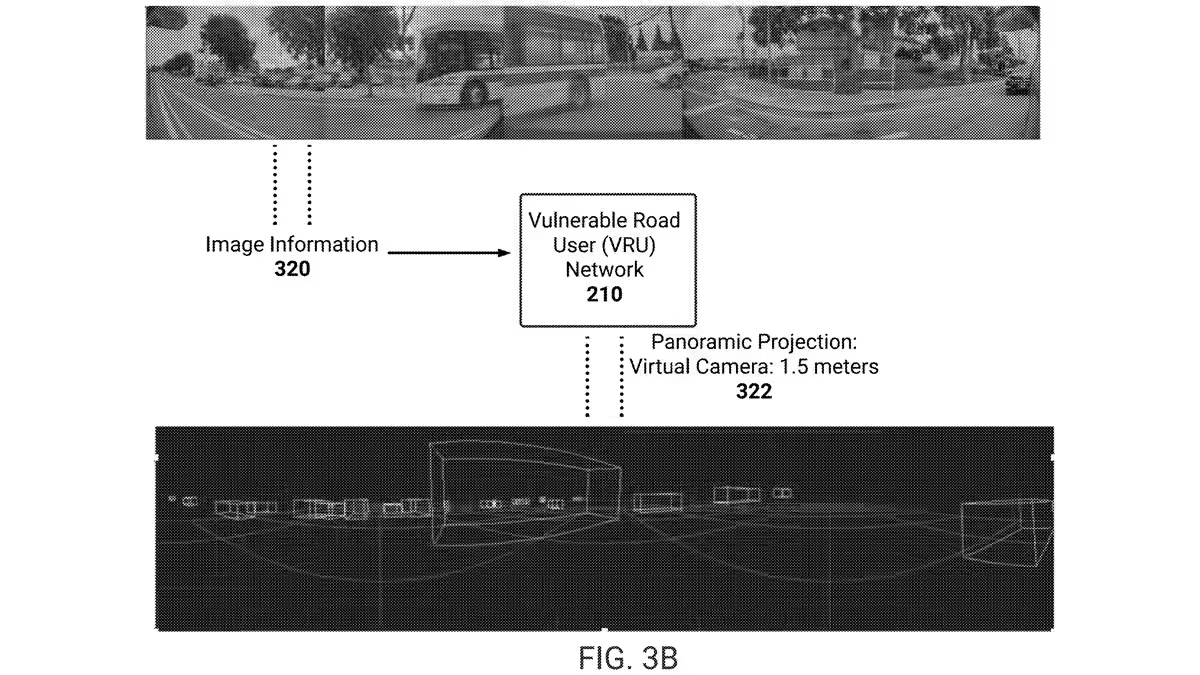

VRU 網路:專為行人與小型物體設計

VRU 網路的虛擬攝影機設定在約 1.5 至 2 公尺的高度,模擬人類的觀看高度,使 FSD 系統能更準確地理解行人、自行車等物體的行為。透過這個高度,系統能獲取更多行人動態的數據,特別是在擁擠的城市路段,VRU 網路能提前預測行人是否可能突然穿越馬路,進而做出適當的行動調整。

VRU 網路的技術特點包括:

- 全景視角:透過虛擬攝影機的全景視角,系統能廣泛觀察周遭行人等物體。

- 固定投影引擎:提供穩定且一致的影像映射,避免 VRU 物體被錯誤識別。

- 向量空間變形:延伸 VRU 物體形狀,使行人和小動物輪廓更加明顯,提升系統識別的精確度。

- 異地速度計算:精確計算 VRU 物體的移動速度,幫助系統快速預測並調整行車路徑。

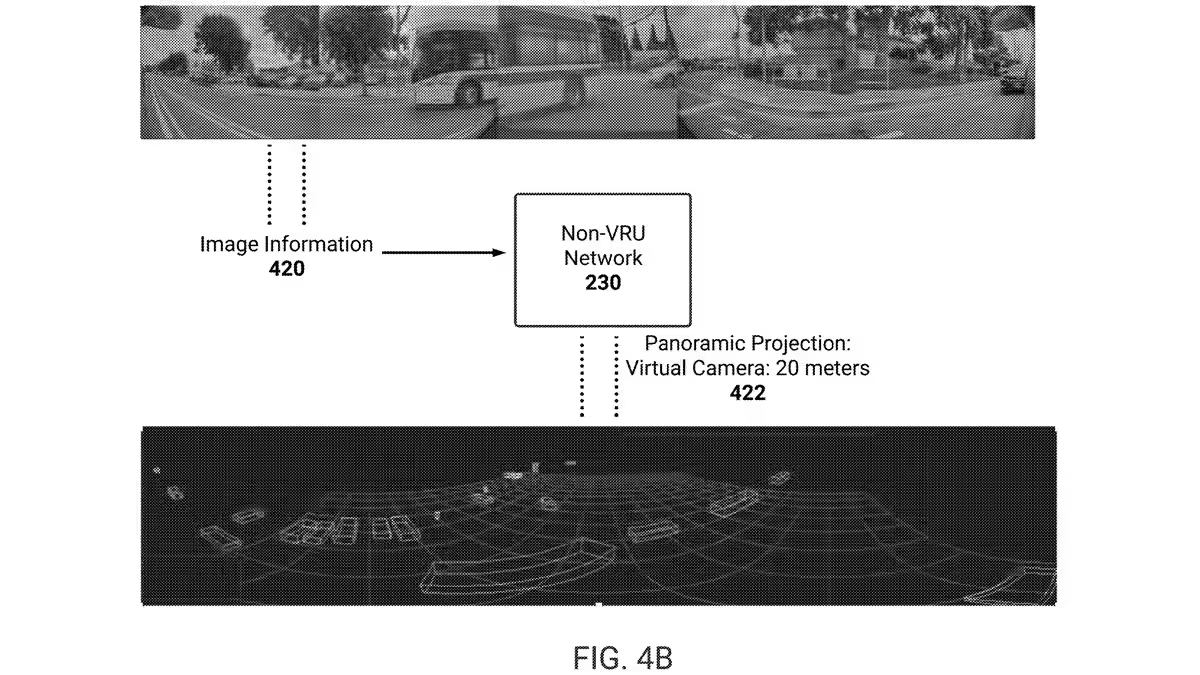

非 VRU 網路:高位視角掌握道路動態

非 VRU 網路主要負責處理其他車輛,虛擬攝影機設定在 15 至 20 公尺的高度,形成類似潛望鏡的視角,使 FSD 系統能從高位俯瞰周邊環境。在高速公路或道路擁擠的情況下,這種視角設定能讓 FSD 系統提前識別遠方車輛的動態,預防突發狀況。

非 VRU 網路的技術特點包括:

- 潛望鏡視角:從高位俯瞰道路,增強遠距離的辨識能力。

- Transformer 網路:透過自適應特徵投影,精確識別道路上不同車輛的特徵。

- 向量空間變形:放大中央區域,便於在車流量大的場景中快速定位目標車輛。

- 自我速度計算:計算系統與其他車輛的相對速度,提供即時判斷,加強行駛穩定性。

超窄模型:專注於近距離物體,提高駕駛精確度

在車輛行駛的路徑上,超窄模型(Super Narrow Model)專注於追蹤和分析位於車輛前方最近的物體(CIPV,最接近的行進中車輛)及其周邊環境。此模型具備精確且高解析度的前視影像處理能力,能在擁擠路況下快速分析近距離物體並即時反應,從而降低碰撞風險。例如,在市區或塞車路段,超窄模型能有效追蹤前車的距離和動態變化,確保與前方車輛保持安全距離。

超窄模型技術包括:

- 高解析度影像處理:針對車輛正前方的影像進行高精度分析,以細緻的方式檢測近距離物體,增強系統在擁擠環境中的精確度。

- 時間標記影像幀整合:透過時間序列分析,整合多幀影像資料以追蹤物體的持續動態變化,使系統能即時應對前方車輛的加減速情況。

- 專用視訊模組:專門負責近距離物體的追蹤和定位,確保系統在應對複雜駕駛場景(如頻繁起步與停止的城市道路)時,依然能精確地做出駕駛決策。

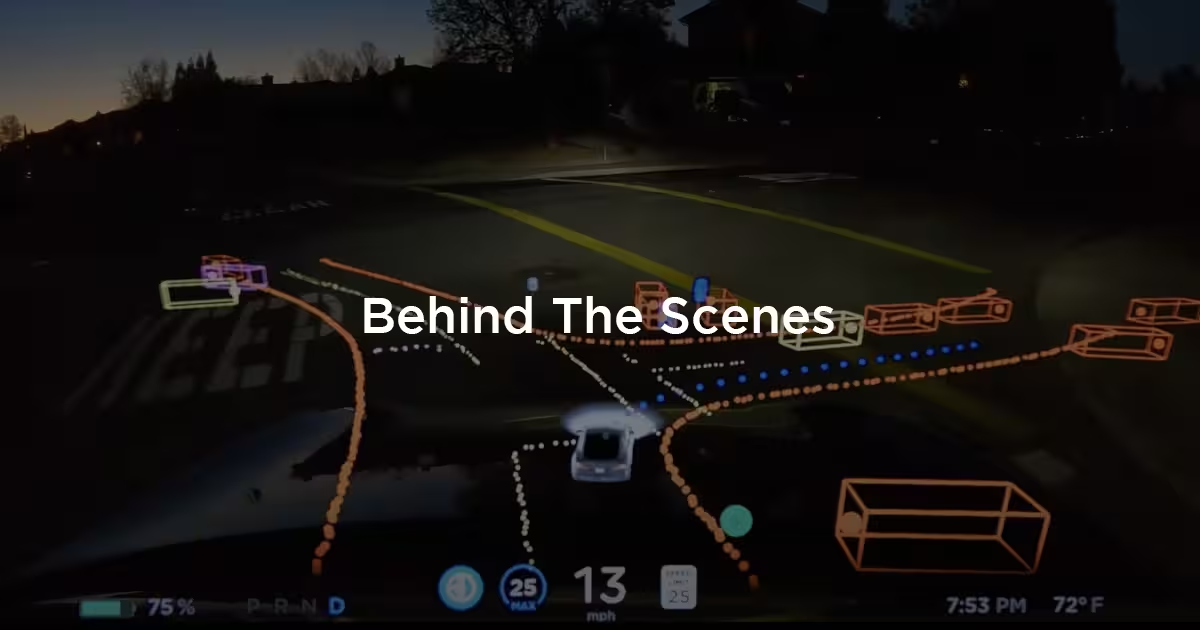

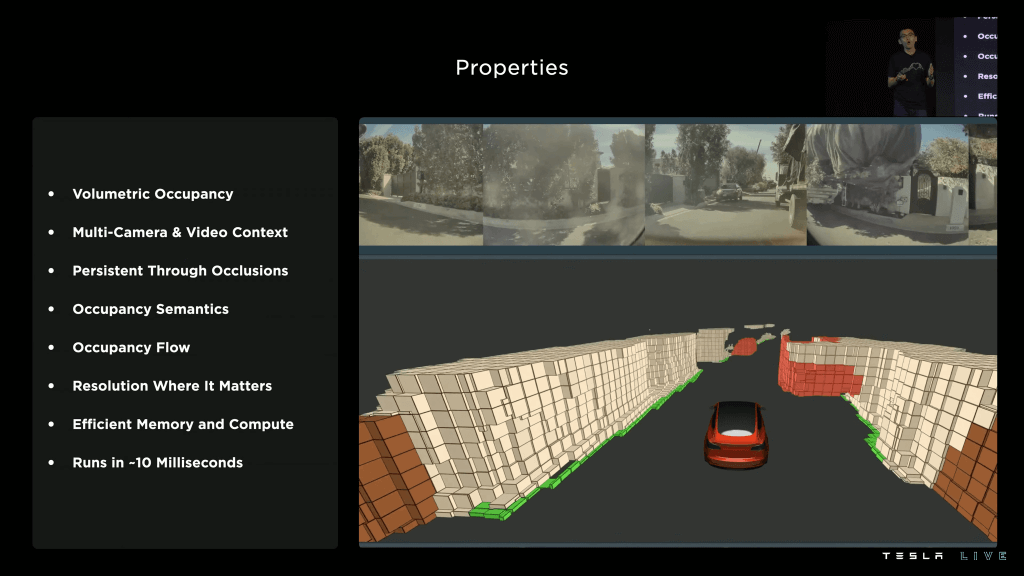

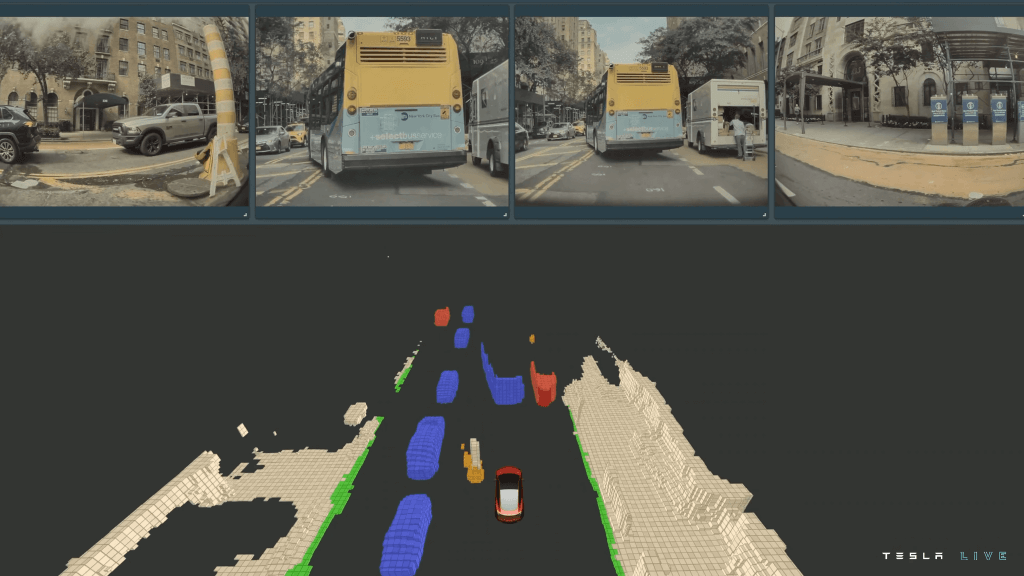

FSD 系統會將 VRU 和非 VRU 網路所收集的數據同步處理,生成車輛周圍的 3D 地圖。該系統結合車輛其他感測器的移動數據(如速度和加速度)進行深入分析,製作出即時更新的三維圖像。這個 3D 地圖相當於車輛的「視覺記憶」,能顯示動態物體的位置和速度,供駕駛決策參考。

在這張三維地圖中,每個物體不僅僅是一個符號,還包含多種屬性。例如,行人具有距離、移動方向和速度等屬性;而車輛則包含寬度、高度、速度和預計行進路徑等資訊。即便是靜態的道路物體(如交通錐),也包含道路寬度、速限等屬性,便於 FSD 在即時環境中進行精確決策。

時序索引技術:即時追蹤並預測物體動向

特斯拉 FSD 系統的另一個關鍵技術是「時序索引」(Temporal Indexing)。此技術讓系統不僅分析單一影像幀,而是結合多幀影像來理解物體的動向。透過「影像模組」持續追蹤物體位置的變化,系統能預測車輛和行人的未來行進方向,即使物體短暫被遮擋,依然能保持追蹤。

例如,當行人短暫被停在路邊的車輛遮擋時,時序索引技術讓 FSD 能透過先前的影像幀推測行人的動向,並為車輛的駕駛決策提供穩定的路徑預測,避免可能的碰撞風險。該技術在車流量大的環境中特別重要,能在視線受阻時準確預測並持續監控物體。

整合視覺系統:多層次協作增強環境理解

特斯拉的整合視覺系統能將 VRU 網路、非 VRU 網路(Peri Net)及超窄模型整合在一起,實現多層次、多角度的環境分析。這樣的整合讓 FSD 系統能夠從不同高度和視角觀察環境,精確辨識並追蹤各類物體,從而實現穩定的駕駛決策。

例如,VRU 網路專門偵測行人和小型物體,非 VRU 網路則負責遠距離大型車輛的追蹤,而超窄模型則專注於車輛正前方的行車距離。這三個系統的協同工作,使 FSD 系統在面對不同路況場景時,能夠提供全面的駕駛支援。

FSD 單車騎士、動物偵測能力與閃紅燈的挑戰

在 FSD v12.5 版本中,特斯拉透過先進的視覺系統實現了多項顯著改善,例如自行車騎士的偵測精度提升,以及在低光環境下對小動物的識別能力增強。這些改進很大程度上歸功於 VRU 網路的專門處理和時序索引技術的加強。

例如,網紅 AI DRIVR 的測試影片展示了 FSD 12.5 在面對自行車騎士時的平順應對,僅通過再生制動即可達成減速,無需使用煞車。此外,FSD 在應對道路上的小動物(如貓)時,能夠即時反應並避免碰撞。

雖然 FSD v12.5 在物體偵測與預測方面有顯著提升,但在處理閃爍紅燈時仍面臨一些挑戰。網紅 DirtyTesla 的測試顯示,FSD v12.5 在應對閃爍的紅燈和黃燈時,成功與失敗的情況參半,顯示 FSD 系統在快速交替的燈號狀態下,有時仍會遇到追蹤難題。這可能與時序索引系統在處理快速變動的燈光狀態上尚未完全穩定有關。

端到端 AI 訓練:強化整體系統效能

這項專利的最後重點在於特斯拉 FSD 的「端到端訓練」技術。FSD 系統從前端到後端都經過 AI 訓練,端到端的訓練模式讓每個模組學習如何協同合作,以最佳化整體系統的運行效率。這代表每個攝影機、每個網路和每個影像處理模組都能在整體架構中自動協調,達到最佳化效果,使 FSD 系統能夠快速且準確地進行路況判斷。

總結來說,特斯拉將 FSD 系統視為「大腦」,而攝影機則是「眼睛」。FSD 可以同時追蹤大量物體,並根據物體的速度、大小、路徑等特性迅速做出行駛決策。透過時序索引、虛擬攝影機和 3D 地圖建構等技術,FSD 能像人類一樣理解並預測道路環境的動態變化,但在準確度和反應速度上遠勝於人類。

延伸閱讀

特斯拉 Autopilot 是自動駕駛嗎?AP、EAP、FSD 有什麼不同?一張表看懂

特斯拉車隊驗證車輛 Fleet Validation Vehicle 在做什麼?台灣即將推出 FSD 全自駕?

特斯拉 FSD 進度報告:必要干預里程提升 4 倍、v13 感恩節前後推出

選購特斯拉新車,可使用 TESLAGURU 的推薦連結 於官網訂購,或告知銷售顧問專屬推薦碼「10788」以獲得最新購車優惠,若您即將交付新車,不妨參考 JOWUA 周邊配件。

如果您覺得 TESLAGURU 的文章對您有幫助,歡迎追蹤 LINE TODAY 並訂閱 Google 新聞,未來搜尋用車知識更容易找到相關文章。